Einleitung

ChatGPT ist beeindruckend – keine Frage. Das KI-Modell von OpenAI kann in Sekunden Aufsätze schreiben, Fragen beantworten, Texte zusammenfassen oder gar kleine Programmieraufgaben lösen. Es klingt kompetent, reagiert schnell und wirkt oft fast menschlich. Kein Wunder, dass es längst in Schule, Studium und Beruf Einzug gehalten hat.

Doch genau das macht es auch gefährlich.

Denn hinter der geschliffenen Sprache steckt kein echtes Wissen, kein Bewusstsein, kein Verstehen. ChatGPT generiert Antworten – basierend auf Wahrscheinlichkeiten, nicht auf Fakten. Was plausibel klingt, ist nicht automatisch richtig. Und wer sich blind auf das Modell verlässt, kann böse Überraschungen erleben: von falschen Zitaten bis zu erfundenen Informationen.

In diesem Blogpost schauen wir kritisch auf die Grenzen von ChatGPT. Wir analysieren typische Fehlerquellen, erklären, wie KI-Modelle ticken – und geben dir praktische Tipps, wie du im Bildungsalltag verantwortungsvoll mit KI umgehst. Ob als Schüler:in, Lehrer:in oder einfach als neugieriger Mensch: Du wirst verstehen, warum du der KI nicht alles glauben solltest – und wo du besser zweimal hinschaust.

1. Die Illusion der Korrektheit

ChatGPT klingt oft so, als hätte es recht. Die Sprache ist flüssig, die Struktur logisch, die Antworten wirken durchdacht. Genau darin liegt eine der größten Gefahren: Wir neigen dazu, Autorität mit Korrektheit zu verwechseln – vor allem, wenn die Antwort schnell und souverän formuliert ist.

Doch ChatGPT ist kein Lexikon. Es ist ein Sprachmodell. Das bedeutet: Es berechnet, welches Wort statistisch am wahrscheinlichsten als Nächstes folgt. Es hat keine Ahnung, ob die Antwort stimmt. Es weiß nicht, was „wahr“ oder „falsch“ ist – weil es kein Wissen im menschlichen Sinn besitzt.

Fallbeispiel: Die erfundene Quelle

Stell dir vor, du fragst ChatGPT nach einer wissenschaftlichen Quelle zu einem bestimmten Thema, zum Beispiel zur Wirkung von Bildschirmzeit auf Jugendliche. Die Antwort kommt prompt – mit Autor, Jahr, Titel und angeblich seriöser Fachzeitschrift. Klingt überzeugend. Doch bei der Gegenprüfung stellst du fest: Diese Quelle existiert nicht.

Das passiert häufiger, als man denkt. ChatGPT kann Quellenangaben halluzinieren – also erfinden –, weil es gelernt hat, wie wissenschaftliche Zitate aussehen, nicht aber, ob sie real sind. Wer das nicht weiß, tappt schnell in die Glaubwürdigkeitsfalle.

KI Fehler

Diese „KI Fehler“ sind nicht nur ärgerlich, sie können in Bildungskontexten gravierende Folgen haben. Schüler:innen übernehmen fehlerhafte Informationen in Referate, Lehrer:innen lassen sich von falschen Argumentationsketten täuschen, und in Prüfungen werden vermeintlich gesicherte Fakten präsentiert, die aus reiner Sprachstatistik stammen.

Was du tun kannst

- Verifiziere jede Information, vor allem bei Zahlen, Zitaten und Quellen.

- Nutze ChatGPT als Ideengeber, nicht als endgültige Auskunft.

- Suche bewusst nach Belegen außerhalb der KI, z. B. in Bibliotheken, Datenbanken oder Fachportalen.

Kurz: Lass dich nicht blenden. Nur weil etwas gut klingt, ist es noch lange nicht richtig.

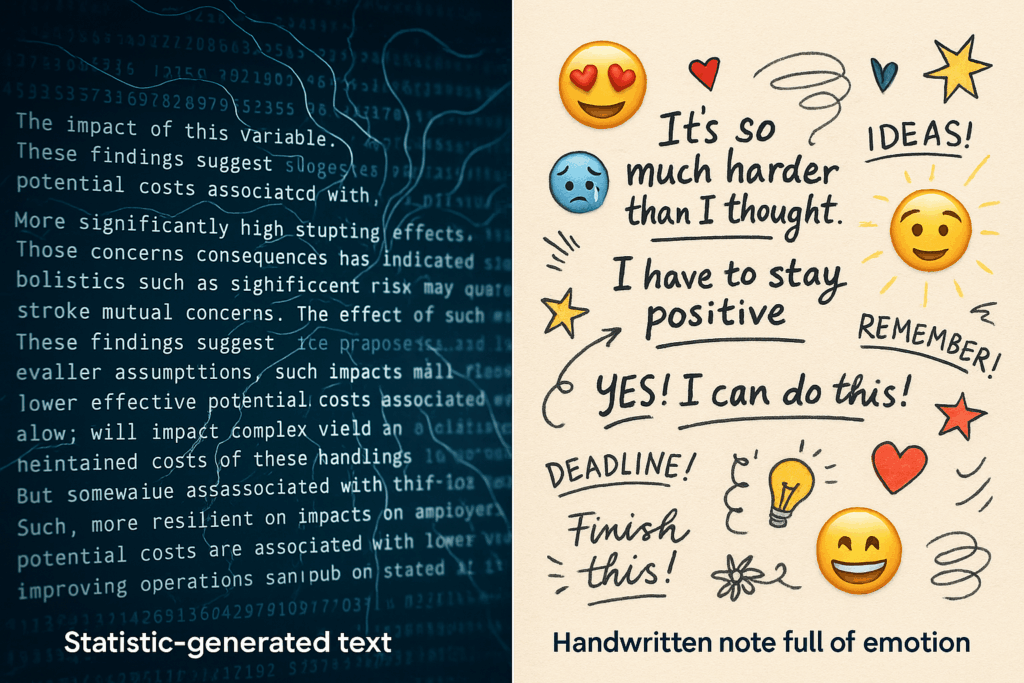

2. Kein echtes Verständnis – nur Statistik

Was ChatGPT kann, ist beeindruckend – aber es versteht nicht, was es tut. Hinter jedem Satz steckt keine Bedeutung im menschlichen Sinne, sondern ein statistisches Modell, das auf Milliarden Textbeispielen trainiert wurde. ChatGPT „weiß“ nicht, dass Paris die Hauptstadt von Frankreich ist. Es hat nur gelernt, dass auf die Worte „Hauptstadt von Frankreich“ mit hoher Wahrscheinlichkeit „Paris“ folgt.

Wie Sprachmodelle funktionieren (vereinfacht erklärt)

Ein Sprachmodell wie ChatGPT analysiert Texte aus dem Internet, Büchern, Artikeln und Foren. Es erkennt Muster, Wahrscheinlichkeiten und typische Formulierungen. Auf dieser Basis berechnet es, wie ein sinnvoller Satz aussehen könnte – so wie ein Musikprogramm Akkorde kombiniert, ohne jemals ein echtes Musikverständnis zu entwickeln.

Das Ergebnis ist ein System, das Sprache beeindruckend gut nachahmt, aber keinerlei Einsicht in die Bedeutung hat. ChatGPT kann über Gefühle schreiben, ohne welche zu empfinden. Es kann philosophieren, ohne zu denken. Es kann diskutieren, ohne zu verstehen.

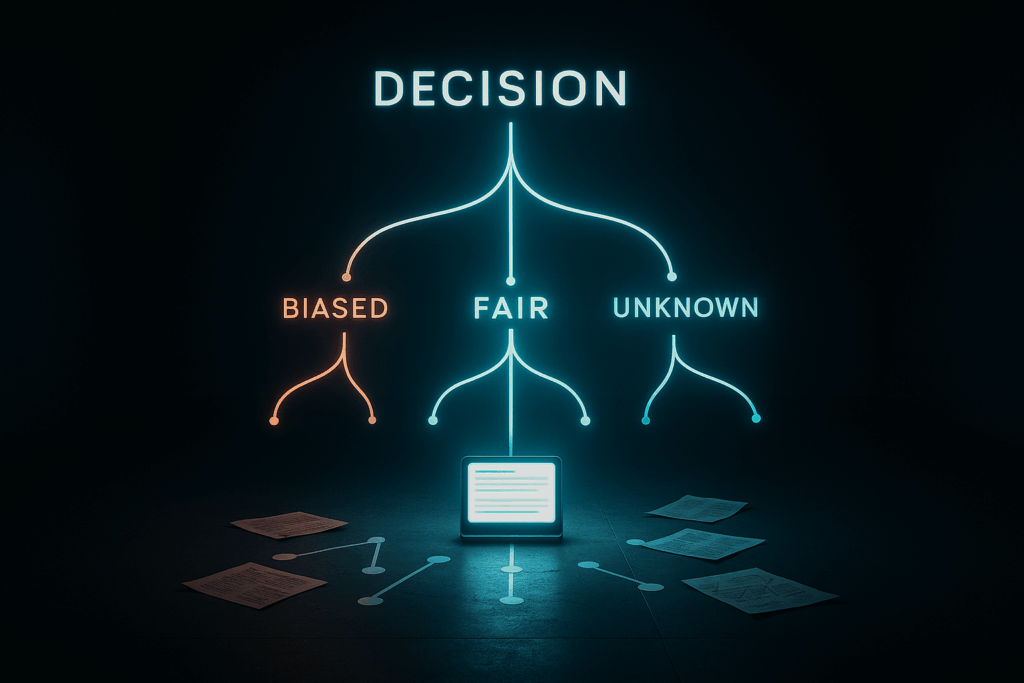

Der Unterschied zwischen Wissen und Wahrscheinlichkeiten

Hier liegt der fundamentale Unterschied zum menschlichen Denken: Menschen verknüpfen Informationen mit Bedeutungen, Emotionen, Erfahrungen. Wir lernen, reflektieren, schließen Schlüsse. ChatGPT hingegen generiert Inhalte auf Basis von Wahrscheinlichkeiten – ohne echte Logik, ohne Ziel, ohne inneren Kompass.

Deshalb passieren auch oft sogenannte „Halluzinationen“: Aussagen, die sprachlich korrekt wirken, aber sachlich falsch oder sinnlos sind. Zum Beispiel:

„Isaac Newton war ein berühmter Biologe, der die Evolutionstheorie aufgestellt hat.“

Klingt auf den ersten Blick vielleicht logisch – ist aber kompletter Unsinn.

Was das für Bildung und Lernen bedeutet

Im Bildungsbereich kann das zu massiven Missverständnissen führen. Lernende könnten annehmen, dass ChatGPT ein objektiver Wissensvermittler sei. Doch das Modell produziert Texte, die wie Wissen aussehen – aber nicht zuverlässig sind. Wer sich dessen nicht bewusst ist, lernt unter Umständen das Falsche.

Deshalb gilt:

- ChatGPT ersetzt kein Schulbuch, keinen Fachartikel, keine Lehrkraft.

- Es kann Impulse geben, beim Verstehen helfen – aber nicht den kritischen Denkprozess übernehmen.

- Besonders bei komplexen, mehrdeutigen oder emotional aufgeladenen Themen ist menschliche Einordnung unersetzlich.

Künstliche Intelligenz ist ein Werkzeug. Und wie bei jedem Werkzeug kommt es darauf an, wer es benutzt – und wie bewusst.

3. Grenzen der Aktualität

ChatGPT weiß viel – aber nicht immer das Neueste. Ein häufig übersehener Punkt bei der Nutzung von Sprachmodellen ist ihr begrenzter Wissenszeitraum. Die Standardversion von ChatGPT basiert auf einem Datenstand, der zu einem bestimmten Zeitpunkt eingefroren wurde. Informationen, die danach veröffentlicht wurden, kennt es nicht – es sei denn, du nutzt eine Variante mit Echtzeitzugriff, wie z. B. mit Websuche.

Veraltetes Wissen im neuen Gewand

Ein gutes Beispiel: Frag ChatGPT nach dem aktuellen Lehrplan deines Bundeslandes oder nach den neuesten Datenschutzregeln in der EU. Die Antwort mag gut formuliert sein – aber sie kann veraltet oder schlicht falsch sein. Denn wenn sich rechtliche Grundlagen, Forschungsergebnisse oder gesellschaftliche Diskurse seit dem letzten Trainingszeitpunkt geändert haben, kennt das Modell diese Entwicklungen nicht.

Ein weiteres Beispiel: Technologische Neuerungen wie neue KI-Modelle, Softwareversionen oder wissenschaftliche Studien nach dem Trainings-Cutoff fehlen schlicht. ChatGPT kann sie weder zitieren noch korrekt einordnen.

Fallbeispiel: Veraltete Gesetzestexte

Eine Lehrerin fragt ChatGPT, ob eine bestimmte Form der Datenverarbeitung an ihrer Schule laut DSGVO erlaubt ist. Die Antwort: ein langer, scheinbar fundierter Absatz mit Verweisen auf Artikelnummern und Begrifflichkeiten. Doch bei genauer Prüfung stellt sich heraus: Die zitierte Regelung wurde bereits durch eine neuere ersetzt – und die Antwort ist damit nicht nur überholt, sondern potenziell irreführend.

Tipps: Wann du besser nochmal selbst googelst

Auch wenn ChatGPT praktisch erscheint – es lohnt sich, bei bestimmten Themen vorsichtig zu sein. Hier ein paar Faustregeln:

- Immer aktuell gegenprüfen bei:

- Recht, Politik und Verwaltung

- Medizin, Gesundheit und Ernährung

- Technik, Software und Wissenschaft

- Suche gezielt nach Veröffentlichungsdatum, wenn du Inhalte recherchierst – gerade bei sensiblen Themen.

- Nutze KI als Einstieg, nicht als Abschluss: Lass dir Begriffe erklären oder Konzepte umreißen, aber hol dir anschließend aktuelle Informationen aus zuverlässigen Quellen.

ChatGPT kann viel – aber tagesaktuelle Recherche gehört (noch) nicht verlässlich dazu. Wer das weiß, kann das Tool trotzdem sinnvoll nutzen – und spart sich später viel Ärger.

4. Fehlende Kontexttiefe

ChatGPT kann Sprache – aber keinen echten Kontext. Das Modell analysiert die Eingabe, erkennt Muster und erzeugt darauf basierend eine Antwort. Doch was oft vergessen wird: ChatGPT kennt dich nicht, kennt deine Situation nicht, und es weiß auch nicht, worauf du im Detail hinauswillst – selbst wenn deine Frage scheinbar eindeutig formuliert ist.

Wenn KI am Thema vorbeiredet

Ein klassisches Beispiel: Eine Schülerin bittet ChatGPT um Hilfe bei einer Gedichtinterpretation. Das Modell liefert eine saubere Analyse – Aufbau, Sprachbilder, Stilmittel. Klingt gut. Doch es fehlt der entscheidende Punkt: der konkrete Unterrichtskontext. Die Klasse hat sich in der Vorwoche mit feministischer Lyrik beschäftigt – doch davon steht in der Antwort kein Wort. ChatGPT interpretiert das Gedicht auf generischer Ebene, ohne Bezug zum aktuellen Lernziel.

Das passiert nicht nur in der Schule. Auch Studierende, die spezifische Hausarbeits-Themen besprechen wollen, bekommen oft oberflächliche Standardantworten. ChatGPT kann eben nicht wissen, was im Seminar diskutiert wurde oder welche Theorien der Dozent bevorzugt.

ChatGPT Schwächen

Diese Art von „Themaverfehlung“ gehört zu den häufigsten ChatGPT Schwächen. Die KI kann zwar auf einzelne Begriffe reagieren – aber oft nicht auf den tieferen Zusammenhang. Selbst wenn du eine längere Unterhaltung führst, reicht der Kontext, den ChatGPT über mehrere Nachrichten behält, nur begrenzt aus, um komplexe Diskussionen wirklich zu verstehen oder sinnvoll weiterzuentwickeln.

Beispiele aus dem Schul- und Uni-Alltag

- Präsentationen: ChatGPT liefert eine sachlich korrekte Zusammenfassung, aber nicht die kreative oder persönliche Perspektive, die von der Lehrkraft gefordert war.

- Hausaufgabenhilfe: Die Lösung ist formal richtig, aber am Aufgabenformat vorbei (z. B. wird eine Tabelle statt einer Grafik verlangt).

- Essay-Vorbereitung: Der Text enthält zwar Argumente – aber nicht im gewünschten Stil oder aus dem geforderten Blickwinkel (z. B. marxistisch, konstruktivistisch, etc.).

Was du tun kannst

- Liefere mehr Kontext in der Anfrage, z. B. Unterrichtsthema, Zielsetzung oder verwendete Begriffe.

- Nutze ChatGPT als Ausgangspunkt, aber passe den Text selbst an deinen Rahmen an.

- Lies genau, ob die Antwort wirklich auf deine Frage eingeht – oder nur so klingt.

Kurz gesagt: ChatGPT kann dir helfen, schneller zu arbeiten – aber es denkt nicht für dich. Du musst beurteilen, ob die Antwort in deinen Kontext passt. Und das erfordert mehr als nur Copy & Paste.

5. Ethik, Bias und gefährliche Empfehlungen

Künstliche Intelligenz ist nicht neutral. Auch wenn ChatGPT sich sachlich und objektiv anhört – hinter jeder Antwort stecken Daten. Und diese Daten kommen aus der Welt, wie sie ist: voller Ungleichheiten, Vorurteile und kultureller Verzerrungen. Das bedeutet, dass auch ein KI-Modell diese Verzerrungen – bewusst oder unbewusst – übernimmt und verstärkt.

Wie gesellschaftliche Vorurteile in KI einfließen

ChatGPT wurde mit Texten aus dem Internet trainiert. Dazu gehören Nachrichtenartikel, Forenbeiträge, Bücher, Wikipedia-Einträge – aber eben auch diskriminierende Kommentare, stereotype Rollenbilder oder einseitige Darstellungen. Selbst wenn problematische Inhalte herausgefiltert wurden, bleiben subtile Muster bestehen, etwa:

- Frauen werden häufiger in pflegerischen oder sozialen Berufen genannt.

- Technische Kompetenz wird häufiger mit männlichen Namen verknüpft.

- Bestimmte Kulturen oder Religionen werden tendenziell klischeehaft beschrieben.

Diese unsichtbaren Bias wirken sich auf die Antworten aus – vor allem dann, wenn Nutzer:innen nicht gezielt dagegensteuern.

Fallbeispiel: Stereotype Antworten

Eine Nutzerin bittet ChatGPT um Vorschläge für Berufsideen für junge Mädchen. Die Antwort enthält viele soziale, kreative und sprachbezogene Berufe – aber kaum technische oder naturwissenschaftliche. Auf den ersten Blick unauffällig – doch bei genauerem Hinsehen zeigt sich ein typisches Rollenklischee. Und das kann langfristig beeinflussen, was Menschen sich selbst zutrauen.

Noch kritischer wird es, wenn ChatGPT medizinische Ratschläge, rechtliche Einschätzungen oder psychologische Empfehlungen gibt. Denn auch hier können ungenaue, überholte oder einseitige Informationen gefährliche Folgen haben – besonders, wenn sie ohne Kontext oder Fachkenntnis übernommen werden.

Warum kritisches Denken immer gefragt ist

- Frage dich: Wäre die gleiche Antwort auch gekommen, wenn eine andere Person gefragt hätte?

- Vergleiche mit verschiedenen Quellen: Wie formulieren Menschen mit anderer Perspektive das Thema?

- Hinterfrage vermeintlich „neutrale“ Antworten: Gibt es versteckte Vorannahmen oder blinde Flecken?

Was das für Bildung bedeutet

Im Unterricht kann der Einsatz von ChatGPT eine gute Gelegenheit sein, über Vorurteile in Sprache, Medien und Technik zu sprechen. Lehrkräfte können gezielt mit problematischen Antworten arbeiten, sie analysieren und hinterfragen lassen – ein idealer Einstieg in Themen wie kritische Medienkompetenz, ethische KI-Nutzung und digitale Mündigkeit.

Denn eines ist klar: KI-Modelle sind keine moralischen Wesen. Sie haben keine Werte, keine Verantwortung, keine Intuition. Deshalb braucht es Menschen, die genau hinschauen – und bereit sind, auch die scheinbar objektiven Antworten infrage zu stellen.

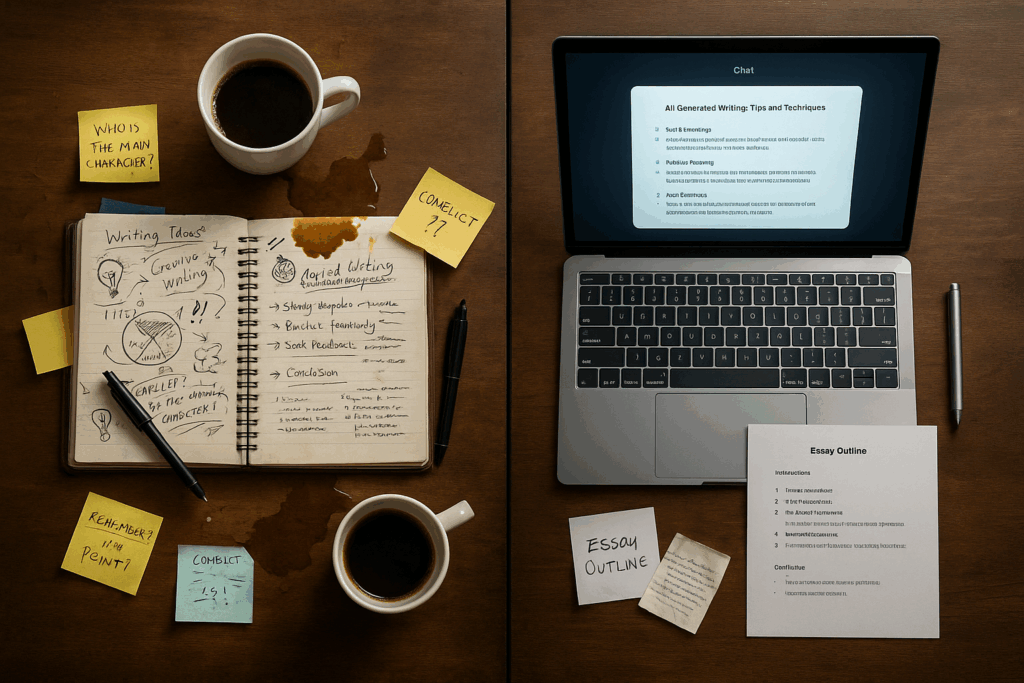

6. Keine kreative Eigenleistung im klassischen Sinn

ChatGPT kann beeindruckende Texte schreiben – aber keine echte Kreativität entfalten. Was auf den ersten Blick wie ein Gedicht, eine Kurzgeschichte oder ein kluger Essay wirkt, ist in Wirklichkeit ein Remix: Das Modell kombiniert bestehende Sprachmuster, Ideen und Strukturen, um etwas „Neues“ zu erzeugen. Doch dieses Neue ist nicht originell im menschlichen Sinn – es ist berechnet, nicht inspiriert.

Was fehlt: Intuition, Erfahrung, Mut

Kreative Eigenleistung bedeutet oft, gegen Regeln zu verstoßen, neue Denkwege zu beschreiten, Ungewöhnliches zu riskieren. Genau das kann ChatGPT nicht. Es bewegt sich – so mächtig es ist – innerhalb der Grenzen seines Trainingsmaterials und der Wahrscheinlichkeiten, die daraus entstehen.

Beispiel: Du lässt dir eine Geschichte schreiben, in der ein Hund das Weltall rettet. ChatGPT liefert eine plausible Handlung, mit Einleitung, Spannungskurve und Auflösung. Alles korrekt – aber nichts davon überrascht dich wirklich. Keine schrägen Einfälle, kein emotionaler Twist, keine literarische Tiefe.

Wo generative KI an ihre Grenzen stößt

- Literatur: ChatGPT kann Stile imitieren, aber keine eigenen erfinden. Es „klingt“ wie Kafka oder Kästner – aber spürt weder Melancholie noch Ironie.

- Kunst und Design: KI kann Bilder erzeugen, die täuschend echt oder fantasievoll wirken. Doch die Entscheidung, warum ein Motiv gewählt wurde, fehlt.

- Unterrichtsplanung: ChatGPT erstellt Aufgaben und Lernziele – doch es kennt keine Klassenatmosphäre, keine individuellen Schüler:innen, keine pädagogischen Nuancen.

Warum das wichtig ist

Im Bildungsbereich bedeutet das: Wer ChatGPT nutzt, bekommt in der Regel gute Vorschläge – aber keine tiefergehenden, persönlichen, innovativen Konzepte. Es fehlt die menschliche Handschrift. Die Fähigkeit, etwas zu schaffen, das wirklich aus dem Ich kommt – und nicht nur aus Datenmustern.

KI als Werkzeug, nicht als Schöpfer

Das heißt nicht, dass generative KI unnütz ist. Im Gegenteil:

- Sie kann Schreibblockaden lösen.

- Sie kann Ideen anregen.

- Sie kann beim Strukturieren helfen.

Aber sie kann nicht der kreative Motor sein – dafür braucht es Menschen, mit Neugier, Haltung und Mut zur Lücke.

Fazit dieses Abschnitts: Wer mit KI arbeitet, sollte sie als Partnerin verstehen – nicht als Autorin. Denn echte Kreativität beginnt dort, wo man etwas tut, das vorher noch niemand gedacht hat. Und das kann keine Statistik der Welt ersetzen.

7. Tipps zur Gegenprüfung und Nutzung im Bildungsbereich

ChatGPT ist kein Ersatz für Denken – aber ein guter Sparringspartner. Wer die Grenzen von ChatGPT kennt, kann es trotzdem sinnvoll nutzen – vor allem in Schule, Studium und Weiterbildung. Entscheidend ist: Wie gehst du mit den Antworten um? Und wie sicherst du dich gegen typische Fehlerquellen ab?

Was Lehrkräfte beachten sollten

- Transparenz fördern: Sprich offen mit Schüler:innen über KI – ihre Chancen, aber auch ihre Schwächen.

- Kritische Aufgabenformate wählen: Statt reiner Faktenabfrage lieber kreative, kontextbezogene Fragestellungen, bei denen bloßes Wiedergeben nicht reicht.

- Fehleranalyse einbauen: Lass KI-generierte Texte im Unterricht gemeinsam analysieren, prüfen, hinterfragen – das schärft das Urteilsvermögen.

- KI-Nutzung klar regeln: Formuliere Schulregeln oder Fachvorgaben zur Nutzung von ChatGPT, z. B. bei Hausaufgaben oder GFS.

Was Schüler:innen und Studierende tun können

- Immer gegenchecken: Egal ob Zusammenfassung, Quellenangabe oder Argument – prüfe jede Information auf Plausibilität und Aktualität.

- Verstehe, bevor du nutzt: Lass dir Dinge von ChatGPT erklären, aber übernimm sie nicht blind. Frag nach, wenn etwas unklar ist.

- Vermeide Copy & Paste: Nutze ChatGPT als Ideengeber, aber formuliere selbst. Das schult Sprache, Stil und Verständnis.

- Bleib neugierig: Nutze die KI, um neue Perspektiven zu entdecken – aber bleib offen für Widersprüche und echte Diskussionen.

Praktische Tools zur Verifikation

- Google Scholar oder BASE: Für wissenschaftliche Quellen

- Perplexity.ai: KI-gestützte Suche mit Quellennachweis

- Wikipedia + Quellencheck: Gute Basis für Einstieg + Vertiefung

- KI-Checker wie GPTZero oder Turnitin AI Detector: Zum Prüfen von KI-generierten Texten

Dos & Don’ts im Alltag mit ChatGPT

✅ Do:

- „Erkläre mir den Unterschied zwischen…“

- „Formuliere diesen Text für ein jüngeres Publikum.“

- „Gib mir drei Sichtweisen auf dieses Thema.“

- „Was sind mögliche Gegenargumente für…“

❌ Don’t:

- „Schreib mir die Hausarbeit.“

- „Welche Quellen kann ich übernehmen?“ (ohne sie zu prüfen)

- „Gib mir die perfekte Lösung.“ (ohne selbst nachzudenken)

Merke: ChatGPT ist ein mächtiges Werkzeug – aber kein Ersatz für Bildung, Recherche und eigenes Denken. Wer es klug einsetzt, kann davon profitieren. Wer es unreflektiert nutzt, läuft Gefahr, Fehler zu verstärken statt Wissen zu vertiefen.

Fazit

ChatGPT ist ein Werkzeug, kein Orakel. Es kann Texte generieren, Ideen liefern, Strukturen vorschlagen – aber es denkt nicht, fühlt nicht, versteht nicht. Und genau deshalb ist es so wichtig, seine Grenzen zu kennen.

In der Bildung kann KI große Chancen bieten: Sie hilft beim Einstieg in komplexe Themen, motiviert zum Schreiben, regt Diskussionen an. Doch wer sie unkritisch nutzt, riskiert Missverständnisse, fehlerhafte Informationen oder stereotype Denkweisen. Besonders in einer Zeit, in der digitale Tools immer selbstverständlicher werden, braucht es einen bewussten Umgang mit Sprache, Quellen und Verantwortung.

Die Grenzen von ChatGPT sind nicht nur technisch – sie sind auch pädagogisch. Denn Lernen bedeutet mehr als Information: Es geht um Einordnung, Reflexion, Perspektivwechsel. All das kann eine KI nicht leisten – aber sie kann Anlass dafür sein, diese Prozesse anzustoßen.

Was bleibt?

- Vertraue nie blind einer Antwort, nur weil sie gut klingt.

- Nutze KI als Gesprächspartner – nicht als Entscheider.

- Lerne, mit Technik kritisch und kreativ umzugehen.

Denn gerade jetzt kommt es auf Menschen an, die nicht nur wissen, was sie sagen – sondern warum.