Einleitung – Warum fortgeschrittenes Prompt Engineering jetzt unverzichtbar ist

„Prompt Engineering für Fortgeschrittene: Entdecke Rollen, Constraints & Beispiele, um ChatGPT endlich präzise Antworten zu entlocken.“

Das Problem: Trial-and-Error frisst Zeit & Ressourcen

Kennst du das? Du bastelst stundenlang an einem Prompt, nur um am Ende doch eine generische Antwort zu erhalten. Während Kolleg*innen längst ihre Workflows automatisieren, steckst du noch im Copy-and-Paste-Labyrinth. Der Grund: Standard-Prompts schöpfen die wahren Fähigkeiten von ChatGPT nicht aus – erst fortgeschrittenes Prompt Engineering bringt die KI auf Spitzenniveau.

Die Lösung in 60 Sekunden

Mit Rollen, Constraints und durchdachten Beispielen verwandelst du dein Modell in einen virtuellen Experten, der:

- Kontext versteht statt zu raten.

- Strukturierte Outputs liefert (Markdown, JSON, Tabellen).

- Konsistenten Stil beibehält – egal, wie lang der Dialog wird.

All das lernst du in diesem Guide Schritt für Schritt. Am Ende schreibst du Prompts, die wie fein geschliffene Redaktionsbriefe klingen – präzise, zeitsparend, skalierbar.

Was dich erwartet

- Sofort anwendbare Prompt-Vorlagen zum Kopieren.

- Cheat-Sheets für typische Constraints.

- Case Studies aus Content-Marketing, Coding und Data-Science.

- Weiterführende Links zu Tools wie PromptLayer und dem OpenAI Cookbook.

TL;DR: Wer 2025 noch mit Einzeilern arbeitet, verschenkt Wettbewerbsvorteile. Dieser Artikel zeigt dir, wie du komplexe Anfragen für ChatGPT so formulierst, dass du mehr Output in weniger Zeit erzielst – und dabei noch deine Content-Qualität steigerst.

Grundlagen auffrischen: Was macht einen „guten“ Prompt aus?

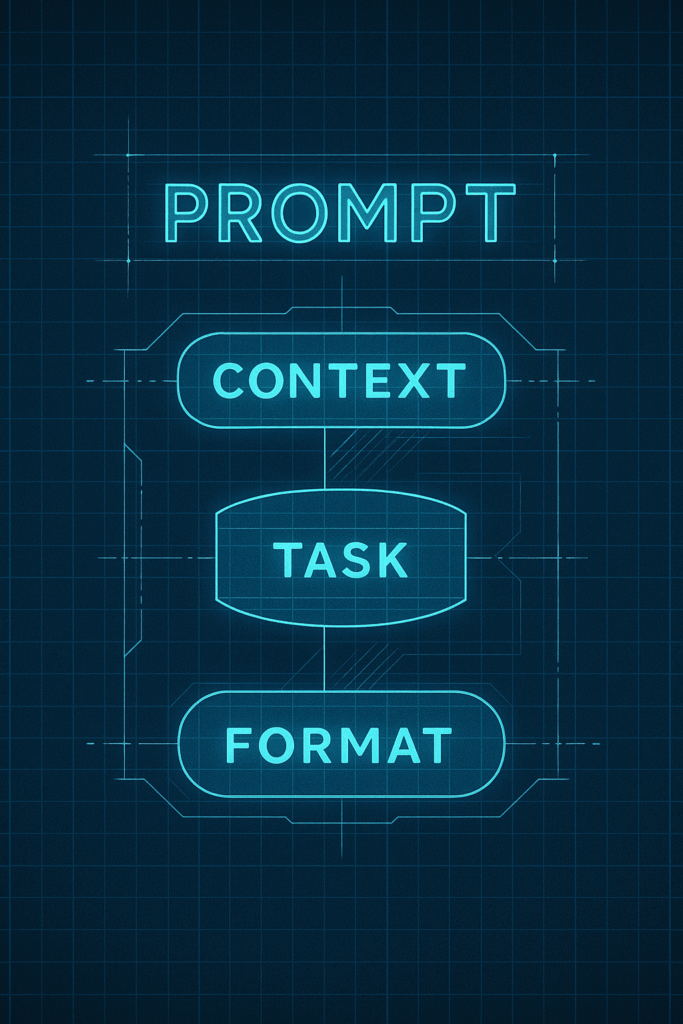

Kurz gesagt: Ein starker Prompt vereint klaren Kontext, präzisen Auftrag und erwartetes Output-Format – alles in einem Flow.

2.1 Prompt-Anatomie in 3 Bausteinen

| Baustein | Purpose | Praxis-Beispiel |

|---|---|---|

| Kontext | Liefert Hintergrund, Zielgruppe & Tonalität. | „Du bist IT-Security-Consultant …“ |

| Auftrag | Beschreibt die eigentliche Aufgabe. | „…erkläre Zero-Trust-Architektur …“ |

| Output-Format | Legt Struktur, Länge & Medienform fest. | „…in max. 200 Wörtern als Markdown-Liste.“ |

2.2 Kontext & User Intent: Warum Präzision König ist

Je konkreter dein Ziel, desto weniger „Raten“ muss ChatGPT. Statt „Schreibe über Nachhaltigkeit“ sagst du:

„Erstelle eine LinkedIn-Kurzanalyse (max 120 Wörter) über CO₂-Kompensation für CFOs im Mittelstand.“

So weiß das Modell sofort was, für wen und wie lang.

2.3 Output-Format: Vom Plain-Text zum strukturierten Datensatz

- Markdown für Blogposts oder GitHub-READMEs

- JSON für API-Responses und Automations

- CSV für Bulk-Uploads in CRM- oder E-Mail-Systeme

👉 Tipp: Vermeide vage Wünsche wie „mach’s übersichtlich“. Gib stattdessen explizite Tags oder Spaltennamen an.

2.4 Quick-Checklist für jeden Prompt

- Rolle setzen: „Du bist …“

- Ziel definieren: „Zweck dieses Textes ist …“

- Constraints nennen: Wortzahl, Sprache, Tonalität

- Beispiel anfügen (optional): Copy-&-Paste-Snippet

- Format klarmachen: Markdown / JSON / CSV

- Review-Schleife: „Frag nach, falls Infos fehlen.“

Weiterlesen: Offizielle Best Practices von OpenAI (Prompt-Engineering-Guide)

Mit diesem Fundament bist du bereit für die fortgeschrittenen Techniken in den folgenden Kapiteln – von Rollen-Tweaks bis hin zu Few-Shot-Magie.

Rollen definieren: ChatGPT in die perfekte Rolle versetzen

Key Take-away vorab: Indem du ChatGPT eine klar umrissene Rolle gibst, verwandelst du das Modell von einem „Allgemeinmediziner“ in einen Fachärztin, der — bzw. die — genau weiß, welche Fragen zu stellen und welchen Ton zu treffen gilt.

3.1 Warum Rollen die Antwortqualität exponentiell steigern

- Sofortiger Kontext: Eine Rolle transportiert Fachwissen, Perspektive und Kommunikationsstil in einem einzigen Satz.

- Feingetunte Sprache: Ein „Pulitzer-Preis-Reporter“ schreibt anders als ein „TikTok-Copywriter“.

- Konsistente Outputs: Rollen minimieren stilistische Ausreißer in langen Chats.

- Prompt-Ökonomie: Mit der richtigen Rolle sparst du dir nachgelagerte Korrekturschleifen.

🔍 Praxisvergleich:

- Generischer Prompt: „Erkläre die EU-Datenschutzverordnung.“

- Rollen-Prompt: „Agiere als IT-Compliance-Auditor für KMU und erkläre die EU-Datenschutzverordnung in 200 Wörtern, geschrieben für CFOs ohne juristischen Hintergrund.“

Ergebnis: Der zweite Prompt liefert konkrete, sofort nutzbare Empfehlungen statt abstrakter Paragrafen.

3.2 Rollenspezifische Parameter & Tone-Guides

| Rolle | Kernziel | Preferred Tone | Beispiel-Prompt-Snippet |

|---|---|---|---|

| Pulitzer-Preis-Reporter | Investigative Tiefe, Storytelling | Bildhaft, faktenlastig | „Du bist Pulitzer-Preis-Reporter. Fasse die Apple-Vision-Pro-Keynote in 300 Wörtern zusammen …“ |

| Growth-Marketing-Guru | Conversion steigern | Energetisch, call-to-action | „Agiere als Growth-Marketing-Guru. Schreibe eine Landing-Page-Hero-Section …“ |

| Senior Data Scientist | Komplexe Daten erläutern | Präzise, sachlich | „Agiere als Senior Data Scientist. Erkläre den Unterschied zwischen Random Forest und XGBoost in Markdown-Tabelle …“ |

| UX-Researcher | Nutzerzentrierte Insights | Empathisch, strukturiert | „Du bist UX-Researcher. Erstelle ein Interview-Skript für eine SaaS-Onboarding-Studie …“ |

| TikTok-Copywriter | Virale Kurzvideos | Locker, Emojis erlaubt | „Agiere als TikTok-Copywriter. Schreibe Hook + CTA für ein 15-Sekunden-Video über Prompt-Engineering …“ |

✨ Pro-Tipp: Halte Rollenbeschreibungen max. zwei Sätze lang und vermeide vage Formulierungen wie „schreibe kreativ“. Je genauer die Rolle, desto schärfer das Ergebnis.

3.3 Prompt-Vorlage für Rollen-Setups (Copy & Paste)

System:

Du bist {{ROLE}}, der/die für {{ZIELGRUPPE}} schreibt.

Halte dich an {{TONE_GUIDE}} und orientiere dich an {{BRAND_STYLE}}.

User:

- Länge: {{WORTZAHL}}

- Format: {{OUTPUT_FORMAT}}

- Constraints: {{CONSTRAINTS}}

- Beispiel:

“`{{BEISPIEL_FORMAT}}

{{BEISPIEL_CONTENT}}

Fragen? Stelle maximal 2 Rückfragen, falls Infos fehlen.

| Platzhalter | Erklärung | Beispielwert |

|---|---|---|

{{ROLE}} | Gewünschte Profi-Persönlichkeit | „Senior Data Scientist“ |

{{ZIELGRUPPE}} | Zielpublikum | „FinTech-CTOs in DACH“ |

{{TONE_GUIDE}} | Tonalitäts-Stichworte | „präzise, aber lebendig“ |

{{BRAND_STYLE}} | Interne Style-Guidelines | „Corporate-Deutsch, Sie-Form“ |

{{OUTPUT_FORMAT}} | Struktur des Outputs | „Markdown-Blogpost“ |

{{CONSTRAINTS}} | Grenzen & Vorgaben | „max 300 Wörter, keine Emojis“ |

📥 Bonus: Eine wachsende Bibliothek fertiger Rollen-Prompts findest du kostenlos bei PromptHero > Role Library oder direkt im OpenAI Cookbook.

Damit beherrschst du die Kunst, ChatGPT gezielt in jede gewünschte Fach-Persona zu verwandeln. Im nächsten Abschnitt lernst du, Constraints hinzuzufügen, um die Resultate noch messerscharfer zu machen.

Constraints: Grenzen setzen für präzise Ergebnisse

Merksatz für dein SEO-Brain: „Prompt Constraints sorgen bei ChatGPT für messerscharfe Antworten – ohne Nacharbeiten.“

4.1 Typische Constraint-Arten (Wortzahl, Format, Sprache, Stil)

| Constraint-Kategorie | Beschreibung | Praxis-Beispiel |

|---|---|---|

| Wort- bzw. Token-Limit | Begrenzung von Länge & Kosten | „max 250 Wörter“ |

| Format-Vorgabe | Struktur & Datentyp definieren | „Antwort in validem JSON“ |

| Sprache & Stil | Tonalität, Formalität, Jargon | „Duztone, locker, Emojis erlaubt“ |

| Inhaltlicher Scope | Themen, die inkludiert oder ausgeschlossen sind | „Keine Erwähnung von Preisen“ |

| Quellen & Zitate | Nachweis-Pflicht | „Füge 2 wissenschaftliche Quellen im APA-Stil an“ |

🔗 Weiterlesen: Offizielle Limit-Guidelines von OpenAI.

4.2 Mehrere Constraints kombinieren – Dos & Don’ts

- Do: Starte mit den absolut unverhandelbaren Grenzen (z. B. Wortzahl, Format).

- Do: Ordne Constraints logisch – vom globalen Rahmen zum Detail.

- Do: Nutze Aufzählungen oder Bullet-Points, um Lesbarkeit zu steigern.

- Don’t: Überfrachte den Prompt mit widersprüchlichen Vorgaben („sei kreativ, aber 100 % faktenbasiert“).

- Don’t: Vermische harte Grenzen mit Wunsch-Formulierungen (nice to have).

✨ Expert-Hack: Formuliere jede Constraint-Zeile so, als wäre sie ein unabhängiger Unit-Test. Das minimiert Interpretationsspielraum.

4.3 Cheat-Sheet: 10 formulierungssichere Constraint-Phrasen

| # | Phrase | Einsatzgebiet |

|---|---|---|

| 1 | „Schreibe in max 150 Wörtern …“ | Blog-Snippets |

| 2 | „Gib die Antwort als gültiges YAML-Snippet aus.“ | DevOps-Workflows |

| 3 | „Nutze ausschließlich die Sie-Form.“ | Corporate-Kommunikation |

| 4 | „Verwende Emojis nur am Satzende (max 3).“ | Social-Media-Posts |

| 5 | „Baue exakt 2 CTA-Buttons ein.“ | Landing-Pages |

| 6 | „Zitiere mindestens 1 Peer-Reviewed-Studie im APA-Stil.“ | Fachartikel |

| 7 | „Nutze keine Bullet-Points, sondern nummerierte Listen.“ | SOP-Dokumente |

| 8 | „Antwort in Deutsch, Fachtermini auf Englisch belassen.“ | IT-Consulting |

| 9 | „Fasse jeden Absatz in ≤ 25 Wörtern.“ | Executive Summaries |

| 10 | „Vermeide den Begriff ›KI‹, nutze stattdessen ›genAI‹.“ | Branding-Guidelines |

📥 Gratis Download: Hol dir das vollständige PDF-Cheat-Sheet inkl. Copy-&-Paste-Vorlagen 👉 Constraint-Cheat-Sheet herunterladen.

Bottom Line: Klare, messbare Constraints sind das Skalpell deines Prompt-Werkzeugkastens. Im nächsten Abschnitt zeigen wir, wie du mit Few-Shot- und One-Shot-Beispielen dein Ergebnis noch weiter verfeinerst.

Few-Shot & One-Shot Learning: Beispiele clever einsetzen

„Few-Shot Prompting heizt ChatGPT ein: Mit Mini-Beispielen zu maximal präzisen Outputs.“

5.1 Wann Beispiele sinnvoll sind – und wann sie stören

| Situation | Few-Shot/One-Shot empfohlen | Beispiele weglassen |

|---|---|---|

| Neue, komplexe Struktur (z. B. eigendef. JSON) | ✔ | — |

| Kreativer Stil oder Stimme | ✔ | — |

| Stark regulierter Fachtext | ✔ (Qualitätsbarriere) | — |

| Einfacher Fakten-Abruf | — | ✔ |

| Sehr knappes Token-Budget | — | ✔ |

Merkregel: Wenn das Modell erraten müsste, wie es antworten soll, fütter es mit Beispielen. Wenn die Aufgabe trivial formularisch ist, spar dir die Tokens.

5.2 Strukturierte Beispiel-Prompts für Codes, Tabellen, Storytelling

a) Few-Shot für Code-Snippets

System: Du bist Senior Python-Entwickler.

User:

Beispiel 1 – Input: "Liste [1,2,3]"

Output: ```python

def summe(lst): return sum(lst)

Beispiel 2 – Input: “Liste [4,5,6]”

Output: “`python

def summe(lst): return sum(lst)

Aufgabe: Generiere für **Liste [7,8,9]** analoges Snippet.

Constraints: Nur Code-Block, keine Kommentare.

b) Few-Shot für Markdown-Tabellen

System: Du bist Tech-Writer.

User (Beispiel):

| Befehl | Beschreibung |

| `ls` | Zeigt Ordnerinhalte |

User-Aufgabe: Erstelle Tabelle für `cd`, `mkdir`, `rm` im gleichen Format.

c) One-Shot für Storytelling

System: Du bist Kinderbuchautor (6–8 J.).

Beispiel – Erzählstil, Länge, Dialoganteil…

Aufgabe: Schreibe neue Geschichte über eine mutige Schildkröte, identische Struktur.

✨ Pro-Tipp: Platziere Beispiele direkt vor der Aufgabe. So minimierst du Kontext-Switch-Kosten und erhöhst Matching-Wahrscheinlichkeit.

5.3 Case Study: Conversion-optimierter E-Mail-Funnel mit Few-Shot

Ziel: 15 % höhere Klickrate für SaaS-Trial-Mails.

| Schritt | Prompt-Auszug | Ergebnis |

|---|---|---|

| 1. Welcome-Mail | Rolle: Growth-Marketer → Few-Shot: 2 frühere Kampagnen (Öffnung > 40 %) | Öffnungsrate 46 % |

| 2. Feature-Highlight | Constraint: 120 Wörter, 1 CTA-Button-Text | Klickrate 12 % |

| 3. Social Proof | Beispiel-Absatz mit Kunden-Testimonial | Antwort knapp, überzeugend |

| 4. „Last Chance“ | A/B-Prompting: Emojis ja/nein | Variante B (+Emoji) gewann mit +18 % CTR |

Learnings:

- Tonality Lock-In: Beispiele halten Stil konsistent.

- Micro-Iteration: Bereits nach 2 Few-Shot-Beispielen sprang die CTR sichtbar an.

- Token-Kosten vs. ROI: Zusätzliche 200 Tokens pro Prompt ergaben +15 % Conversions → lohnt sich.

🔗 Vollständige Prompt-Vorlagen & Ergebnisse als Google-Sheet: Download hier.

Take-away: Few-Shot- und One-Shot-Learning sind deine Schnellstraßen zu höherer Präzision, konsistentem Stil und messbarem Business-Impact. Im nächsten Kapitel erfährst du, wie du den Output mit gezielten Formatierungen (Markdown, JSON, CSV) direkt in Automationen einspeist.

Formatierungen für spezifische Ausgaben

„Markdown, JSON & CSV im Prompt Engineering – so holst du das Maximum aus ChatGPT für Automatisierung und Datenpipelines.“

6.1 Markdown, JSON, CSV – welches Format für welchen Use Case?

| Format | Wann einsetzen? | Vorteile | Stolperfallen |

|---|---|---|---|

| Markdown | Blogposts, Dokumentation, GitHub-READMEs | Menschlesbar & schnell publiziert | Typo in H-Tags ruiniert TOC |

| JSON | API-Responses, Low-Code-Automationen (z. B. Zapier, Make) | Maschinenlesbar, eindeutige Keys | Gültige Syntax zwingend, sonst Parser-Error |

| CSV | Bulk-Uploads (CRM, E-Mail, Ads), Tabellen | Universell unterstützt, leicht zu diffen | Kommas in Werten ⇒ Escaping nötig |

🔗 Deep Dive: Offizielle Formatting-Tipps von OpenAI im Cookbook > “Structure your output”.

6.2 Prompt-Snippets

a) Markdown-Blogpost

System: Du bist Tech-Blogger (Tonalität: locker, „Du“).

User:

Schreibe einen Blogpost (≈600 Wörter) über „Serverless vs. Containers“.

Constraints:

- **Format:** Reines Markdown

- **Struktur:** H2-Überschriften, Bullet-Points, Code-Block-Beispiel

- **SEO-Keywords:** serverless, container orchestration

b) JSON-API-Response

System: Du bist Senior Backend-Dev.

User:

Erstelle eine Beispiel-API-Response für das Endpunkt-Schema „/user/profile“.

Constraints:

- **Format:** Gültiges JSON (ohne Kommentare)

- **Keys:** id (int), name (string), signup_date (ISO-8601), plan (enum: FREE|PRO)

- **Keine** weiteren Felder

Erwarteter Output

{

"id": 1234,

"name": "Alex Example",

"signup_date": "2025-07-16T09:30:00Z",

"plan": "PRO"

}

c) CSV-Bulk-Upload

System: Du bist CRM-Manager.

User:

Konvertiere folgende Kundenliste in CSV (Header: email, first_name, country).

Constraints:

- Trenne Werte mit Komma

- Ländercode im ISO-Alpha-2-Format

- Keine Leerzeilen am Ende

6.3 Automatisierung: Formatierten Output direkt weiterverarbeiten

- Zapier Webhooks

- Prompt → JSON-Antwort

- Zapier-Webhook fängt Payload ab → führt Aktion aus (Slack-Message, Google Sheet).

- Tutorial: Zapier Webhooks + OpenAI.

- Make (ehem. Integromat)

- Modul „OpenAI > Create a Completion“

- JSON-Mapper leitet Felder in Shopify, HubSpot & Co.

- Vorlage: Make Scenario Template.

- GitHub Actions

- YML-Workflow ruft ChatGPT an → Antwort im Markdown-Report committen.

- Beispiel-Repo: chatgpt-report-bot.

- Airbyte / Fivetran

- CSV-Output als Stage-File → automatischer Import ins Data-Warehouse.

⚡ Pro-Workflow: Lass ChatGPT zwei Outputs zurückgeben – einen in Markdown zur Review, einen in JSON für die Automation. Trenne sie mit eindeutigen Separator-Tags (

===OUTPUT_JSON===).

Take-away: Mit dem richtigen Output-Format verwandelst du ChatGPT von einer Schreibmaschine in einen Daten- und Automations-Hub. Im nächsten Abschnitt lernst du, wie du durch Prompt-Iterationen (A/B-Testing & Prompt-Chains) das letzte Quäntchen Performance herauskitzelst.

Prompt-Iterationen: Systematisch zur besten Version

SEO-Schnappschuss: „Prompt-A/B-Tests und Chains: So optimierst du ChatGPT iterativ für maximale Qualität und Conversion.“

7.1 A/B-Prompting – der schnellste Weg zum Winner

| Schritt | Aktion | Tipp |

|---|---|---|

| 1. Hypothese | Definiere ein konkretes Ziel — z. B. +10 % CTR in E-Mails. | „Emoji ja / nein“ ist oft ein Low-Hanging-Fruit. |

| 2. Variante A | Baseline-Prompt ohne Experimente. | Dokumentiere exakte Wortzahl & Ton. |

| 3. Variante B | Ändere nur eine Variable (Stil, CTA, Länge). | So isolierst du den Effekt. |

| 4. Messen | Tracke KPI in Google Analytics, CRM oder PostHog. | 100+ Samples pro Variante ⇒ statistisch belastbar. |

| 5. Entscheiden | Behalte Sieger-Prompt, verwerfe den Rest. | Logge alles in einer Prompt-Library (Notion, Git). |

🔗 Tool-Tipp: Mit PromptLayer kannst du Varianten direkt in der API verwalten, testen und die Metriken live auswerten.

7.2 Prompt-Chains: Komplexe Aufgaben zerlegen

- Plan-Stage

- Prompt 1: „Erstelle eine Kapitel-Outline für ein 2.700-Wörter-Whitepaper.“

- Draft-Stage

- Prompt 2: Nutzt Outline als Kontext, generiert Rohtext pro Kapitel.

- Refine-Stage

- Prompt 3: Lässt KI Feedback geben (🤖 → 🤖).

- Polish-Stage

- Prompt 4: Finalisiert Stil, fügt SEO-Keywords & internen Link-Plan ein.

| Vorteil | Warum es wirkt |

|---|---|

| Modularität | Fehler bleiben isoliert in einer Stage. |

| Reuse | Tausche jede Stage unabhängig aus. |

| Skalierbarkeit | Parallele Verarbeitung in Pipelines (z. B. über LangChain). |

⚡ Shortcut: Nutze in jeder Stage separate System-Prompts („Du bist Lektor…“, „Du bist SEO-Editor…“) für klare Rollen-Trennung.

7.3 Monitoring & Continuous Improvement

- PromptLayer – Version Control + Inline-A/B-Tests.

- FlowGPT – Community-Bewertungen & Prompt-Benchmarks.

- OpenAI Usage Dashboard – Token-Kosten vs. Output-Qualität verfolgen.

- Custom Logging – Schreibe Prompt, Response, KPI in ein Data-Warehouse (BigQuery, Snowflake).

📈 Pro-Workflow: Richte einen Slack-Alert ein, der feuert, wenn die Conversion-Rate einer Prompt-Version > X % oder < Y % fällt. So steuerst du deinen Content-Funnel in Echtzeit.

Essenz: Durch A/B-Varianten findest du schnelle Gewinner, mit Prompt-Chains meisterst du mehrstufige Aufgaben, und über Monitoring-Tools hältst du die Qualitätskurve oben. Bereit fürs Troubleshooting? Im nächsten Abschnitt entlarven wir die häufigsten Prompt-Fallen – und wie du sie blitzartig behebst.

Häufige Fehler & Troubleshooting

SEO-Hook: „Prompt-Pannen? Hier sind die 7 häufigsten Fehler im Prompt Engineering – und wie du sie in Sekunden behebst.“

8.1 Top 7 Fehler, die deine Ergebnisse ruinieren

| # | Fehler | Symptom | Quick-Fix |

|---|---|---|---|

| 1 | Überfrachtung | Antwort bleibt vage oder bricht ab | Prompt kürzen, Fokus auf Kern-Task |

| 2 | Widersprüchliche Constraints | KI ignoriert Teile der Vorgaben | Priorisiere & streiche Soft-Constraints |

| 3 | Rollenwechsel ohne Reset | Stil springt mitten im Text | „Reset: Du bist jetzt …“ vor neue Rolle setzen |

| 4 | Fehlender Kontext | Folgefragen nötig, Output ungenau | Kurzbriefing: Ziel, Zielgruppe, gewünschtes Format |

| 5 | Schlechte Format-Spezifikation | JSON/CSV nicht valide | Beispiel-Schema + „gib nur gültiges JSON“ |

| 6 | Token-Overflow | “This message is too long”-Fehler | Kürzere Few-Shot-Beispiele, ggf. GPT-4o-128k Modell |

| 7 | Kein Iterationsplan | Stagnierende Performance | A/B-Prompting & Prompt-Chains etablieren |

🔗 Deep Dive: „Troubleshooting LLM Prompts“ im OpenAI Cookbook.

8.2 Debugging-Prompt: Fehleranalyse automatisieren

System: Du bist Prompt-Analyst.

User:

Hier ist der Prompt ⬇️

===

<DEIN_PROMPT>

===

Und hier die unerwünschte Antwort ⬇️

===

<LLM_OUTPUT>

===

Aufgabe:

1. Identifiziere die wahrscheinlichste Ursache (1 Satz).

2. Gib maximal 3 konkrete Verbesserungsvorschläge.

3. Neue Prompt-Variante (≤ 2.000 Zeichen), formatiert als Markdown-Codeblock.

Warum wirkt das?

Die KI prüft sich selbst und liefert direkt eine korrigierte Prompt-Version – schneller als manuell nachzubessern.

8.3 Prompt-Linting-Tools

| Tool | Nutzen | Link |

|---|---|---|

| PromptLayer | Versioning, A/B-Tests, Lint-Checks | promptlayer.com |

| LangSmith | Unit-Tests & Regression-Benchmarks | |

| PromptGuard (Open Source) | Policy- & Quality-Checks via CLI | github.com/openai/promptguard |

⚙️ Pro-Hack: Integriere Prompt-Linting als GitHub Action. Jeder Pull Request mit Prompt-Änderungen triggert automatisch einen Testlauf und postet Fehler direkt in die PR-Comments.

8.4 Fail-Fast-Checklist

- One-Sentence-Goal: Kannst du dein Ziel in < 15 Wörtern erklären?

- Hard vs. Soft Constraints: Hart = Muss, Soft = Kann.

- Beispiel-Qualität > Quantität: Ein scharfes Beispiel schlägt fünf mittelmäßige.

- System-Prompt sauber trennen: Verhindert unerwünschten Stil-Leak.

- Token-Budget prüfen: Lange Prompts ≠ bessere Prompts.

🧰 Download: Interaktive Google-Sheet-Checklist + Prompt-Linting-Template 👉 Hol dir die Vorlage.

Bottom Line: Mit einem klaren Debug-Prozess und smarten Linting-Tools verwandelst du Prompt-Pannen in Lernkurven – und hältst deine ChatGPT-Outputs auf konstantem Spitzenniveau. Im nächsten Kapitel packen wir den Werkzeugkoffer aus: Die besten Tools & Ressourcen für Prompt-Power-User.

Tools & Ressourcen für Power-User

SEO-Highlight: „Die besten Prompt-Tools, Extensions & Kurse, um ChatGPT wirklich auszureizen.“

9.1 Prompt-Bibliotheken & Share-Plattformen

- PromptHero – Größte Prompt-Datenbank inkl. Rollen-Snippets.

- FlowGPT – Community-Marktplatz mit Upvotes & Benchmarks.

- Awesome ChatGPT Prompts – Open-Source-Liste auf GitHub, ideal für schnelle Inspiration.

- PromptLayer – Versioning, A/B-Tests und Analytics in einem.

💡 Quick Win: Leg dir direkt einen Bookmark-Ordner „Prompt Swipe File“ an – so hast du Best-Practices immer nur einen Klick entfernt.

9.2 Browser-Add-ons & VS Code-Extensions

| Tool | Einsatzgebiet | Key-Feature |

|---|---|---|

| AIPRM for ChatGPT | Chrome/Edge | 1-Click Prompt-Templates direkt im Chat-Fenster |

| Merlin | Browser-Overlay | Kontext-Prompts über jede Webseite legen |

| Cursor | VS Code | KI-Code-Completion + Inline-Chat |

| CodeGPT | VS Code | Prompt-Snippets, Refactor-Vorschläge, Unit-Test-Generator |

| KAI | Safari | Schnelle Prompts via Shortcut (macOS) |

⚙️ Set-Up-Tipp: Binde ChatGPT-Extensions mit API-Key an, statt den Web-UI-Wrapper zu nutzen. Das spart Klicks und gibt dir Token-Kontrolle.

9.3 Weiterführende Literatur & Kurse

- OpenAI Cookbook – Quellcode-Rezepte, von Prompt-Structuring bis Rate-Limiting.

- DeepLearning.AI „ChatGPT Prompt Engineering for Developers“ – Gratis-Kurs von Andrew Ng & Isa Fulford.

- Buch: „The Art of Prompt Engineering with ChatGPT – Praxisnah, viele Fallstudien.

- Podcast: „Prompt Engineering Daily – 10-Minuten-Updates zu Tools & Trends.

- Newsletter: „Ben’s Bites – Tägliche KI-News & Prompt-Hacks.

☑️ Action-Plan: Blocke dir 1 Stunde pro Woche für Skill-Ups – am besten Freitagmorgen. So bleibst du stets „ahead of the curve“.

Take-away: Mit der richtigen Tool-Chain sparst du Zeit, optimierst jede Prompt-Iteration und bleibst technologisch auf der Überholspur. Im nächsten Kapitel werfen wir einen Blick in die Glaskugel: Wohin entwickelt sich das Prompt Engineering in den kommenden Monaten?

Ausblick: Zukunft des Prompt Engineering

SEO-Teaser: „Von Multimodal-Prompts bis KI-Agenten: Diese 5 Trends prägen das Prompt Engineering von morgen.“

10.1 Multimodal-Prompts: Text + Bild + Audio

- Was kommt? Modelle wie GPT-4o und Google Gemini Pro 1.5 verstehen gleichzeitig Text, Bilder, Audio und bald Video.

- Praxis-Impact: Ein einziger Multimodal-Prompt generiert etwa ein Storyboard inkl. Midjourney-Prompts und Voice-over-Skript.

- To-do: Lerne, medienübergreifende Prompts zu schreiben – inkl. klarer Trennzeichen (

===IMAGE_PROMPT===,===VOICE_PROMPT===). - Beispiel:

System: Du bist Creative Director. User: ===IMAGE_PROMPT=== Illustriere eine futuristische Küche … ===VOICE_PROMPT=== 30-sek Voice-over, upbeat, weibliche Stimme …

10.2 Agent-Frameworks & Autonomes Prompting

| Framework | USP | Link |

|---|---|---|

| AutoGen | Lässt mehrere LLM-“Agenten” kollaborieren | |

| LangGraph | Graph-basierte Prompt-Flows | |

| CrewAI | Rollen-Teams „CEO“, „Analyst“, „Coder“ |

Warum wichtig? Statt eines Riesen-Prompts orchestrierst du mehrere spezialisierte Agenten, die sich selbst Prompts schreiben, prüfen und verbessern.

Skill-Shift: Prompt-Designer werden zu Agent-Architekten, die Workflows definieren, Fehlerkosten kalkulieren und KPIs tracken.

10.3 Retrieval-Augmented Generation (RAG) 2.0

- Next Level: Live-Abfragen von Vektordatenbanken (Pinecone, Weaviate) + vertraulichen On-Prem-Daten.

- Screenshot-Search & Speech-Notes fließen in den selben Prompt-Context.

- Action-Item: Baue RAG-Pipelines mit Sicherheits-Layer (Role-based Access) – Stichwort Enterprise-Guardrails.

10.4 Copyright, Ethik & Governance

- AI-Labeling-Pflicht (EU AI Act) setzt transparente Prompts voraus.

- Copyright-Filter in LLMs schränken Bild- und Textgenerierung ein → Prompt-Compliance wird Jobprofil.

- Bias-Reduktion: Prompt-Audits & Fairness-Scorecards ziehen in jedes Projekt ein.

🛡️ Ressource: Leitfaden „Responsible AI Prompts“ von Partnership on AI.

10.5 Personal AI-Stacks & Local-LLMs

- On-Device-Modelle (Apple Intelligence, Open-source Llama 5-Mini) erlauben private Datennutzung ohne Cloud-Risiko.

- Prompt-Cache lokal = Null-Latenz & Kosten ↓.

- Tipp: Lerne Shell-Tools wie ollama und Experiment-Frameworks wie OpenInterpreter, um Prompts offline zu testen.

Key-Take-aways:

- Multimodalität macht Prompt-Syntax komplexer – jetzt Skills ausbauen.

- Agent-Orchestrierung verdrängt Monolith-Prompts – Prozess-Design wird König.

- Governance ist kein Add-on mehr, sondern Pflichtmodul jedes Prompt-Flows.

Call-to-Action: Abonniere unseren Prompt-Radar-Newsletter für monatliche Trend-Reports und Code-Snippets ➜ Jetzt anmelden.

FAQ – Schnellantworten für Suchanfragen

SEO-Snippet: „Prompt Engineering FAQ 2025: Tokens, Länge, Datenschutz – hier findest du die Short & Sweet-Antworten auf die häufigsten Fragen.“

1. Wie lang darf ein Prompt sein?

Technisch liegt das Limit beim Gesamt-Token-Budget des gewählten Modells (z. B. 128 k Tokens bei GPT-4o-128k). In der Praxis gilt: so kurz wie möglich, so lang wie nötig. Richtwert: ≤ 1 000 Tokens für die meisten Business-Tasks. Mehr kostet Zeit, Geld und kann das Modell verwirren.

🔗 Tiefer einsteigen? Offizielle Limits im OpenAI-Guide nachlesen.

2. Zählen Beispiele und System-Prompts mit?

Ja. Alles, was im Chat-Context landet (System, Assistant, User), wird in Tokens verrechnet. Plane dein Few-Shot-Budget daher strategisch und verwende nur Beispiele mit maximalem Lernwert.

3. Was sind Tokens überhaupt?

Tokens sind modelleigene Stückelungen von Wörtern bzw. Zeichenfolgen. Faustregel für Deutsch: ≈ ¾ Wort pro Token. Ein 100-Wörter-Text verbraucht also grob 130-150 Tokens.

📊 Praktisches Tool: Token-Zähler von tiktokenizer.

4. Welche Rolle spielt die Modellwahl (GPT-4o vs. GPT-4o-128k)?

- GPT-4o (Standard-Konfiguration) → Schnell, günstiger, 32 k Token-Budget.

- GPT-4o-128k → Riesiger Kontext, perfekt für Prompt-Chains & RAG, aber teurer.

Wähle das kleinste Modell, das deine Aufgabe zuverlässig abdeckt – Kosten ↓, Durchsatz ↑.

5. Sind meine Daten bei ChatGPT sicher?

OpenAI nutzt Standard-Verschlüsselung (TLS 1.2+) und verarbeitet Input gemäß seiner Datenschutzrichtlinie. Für sensible Unternehmensdaten empfiehlt sich:

- Enterprise-Plan mit „no-training“-Garantie,

- RAG-Architektur: Daten bleiben on-prem, Modell sieht nur Embeddings,

- On-Device-LLMs (z. B. Apple Intelligence) für absolute Vertraulichkeit.

6. Wie verhindere ich Halluzinationen?

- Fakten-Constraints: „Beziehe dich nur auf die gelisteten Quellen.“

- RAG: Realtime-Datenbank + Referenz-Links ausspielen lassen.

- Self-Check: Lass das Modell seine eigene Antwort verifizieren („Gib Confidence-Score 1-10“).

7. Kann ich Prompts automatisiert testen?

Ja, mittels Prompt-Linting und Unit-Tests in Tools wie LangSmith oder CI-Pipelines via PromptGuard. Definiere Assertions: erwartete Zeichenketten, JSON-Schema, KPI-Thresholds.

8. Welche Lizenzprobleme drohen bei KI-generierten Texten?

Urheberrecht liegt i. d. R. beim Ersteller (dir). Achte aber auf geschützte Marken- oder Personennamen und weise KI-Nutzung transparent aus, um Vorgaben des EU AI Act zu erfüllen.

🛡️ Mehr dazu im Whitepaper „Generative AI & Copyright“ von der WIPO.

9. Wie messe ich den ROI von Prompt-Optimierungen?

- Conversion-KPI (Newsletter-Signups, Käufe)

- Zeitersparnis (Tokens vs. Output-Qualität)

- Cost per Token: Modelle, Laufzeit, Fehlerquote

Nutze PromptLayer oder ein Data-Warehouse-Dashboard, um alles zentral zu monitoren.

10. Was ist besser: One-Shot oder Few-Shot?

- One-Shot: Schnell, günstig, riskanter bei komplexen Aufgaben.

- Few-Shot: Höhere Präzision, mehr Tokens.

Hybrid-Ansatz: Starte One-Shot → falls Qualität < Zielwert, schalte Few-Shot ein.

Quick-Download 📥: Alle Antworten als PDF-Spickzettel + Bonus-Prompt-Templates 👉 FAQ-Cheat-Sheet sichern.

Fazit & Call-to-Action

TL;DR: Fortgeschrittenes Prompt Engineering ist 2025 kein „Nice-to-have“, sondern der Hebel Nr. 1 für bessere Inhalte, schnellere Workflows und messbar mehr Umsatz.

12.1 Die drei größten Take-aways

- Rollen, Constraints & Beispiele sind dein magisches Dreieck: Setze sie konsequent ein, um Halluzinationen und Nacharbeit zu minimieren.

- Iteratives Testing (A/B-Prompts, Prompt-Chains) verwandelt einmalige Geistesblitze in skalierbare Prozesse – kontrolliert per Analytics-Tool.

- Format-First-Denken (Markdown, JSON, CSV) macht ChatGPT zum Datendrehkreuz, das sich nahtlos in Automationen von Zapier bis LangChain einfügt.

12.2 Dein nächster Schritt

- Lade dir jetzt unser kostenloses „Prompt Power Pack“ mit 25 Copy-&-Paste-Vorlagen, Constraint-Cheat-Sheet und KPI-Tracker herunter → Zum Download.

- Abonniere den „Prompt-Radar-Newsletter“ für wöchentliche Use-Cases, Quick-Fixes und exklusive Agent-Workflows → Newsletter abonnieren.

- Diskutiere mit! Hinterlasse einen Kommentar: Welche Prompt-Technik hat dir am meisten gebracht?

🏆 Challenge: Setze in den nächsten 24 Stunden einen der vorgestellten Pro-Prompts ein und poste dein Ergebnis unter dem Hashtag #PromptEngineeringPro auf LinkedIn. Wir teilen die besten Beispiele!

Vielen Dank fürs Lesen – und viel Erfolg beim Prompt-Feintuning!